#012 Glosario de CRO orientado al dato

La práctica hace al maestro

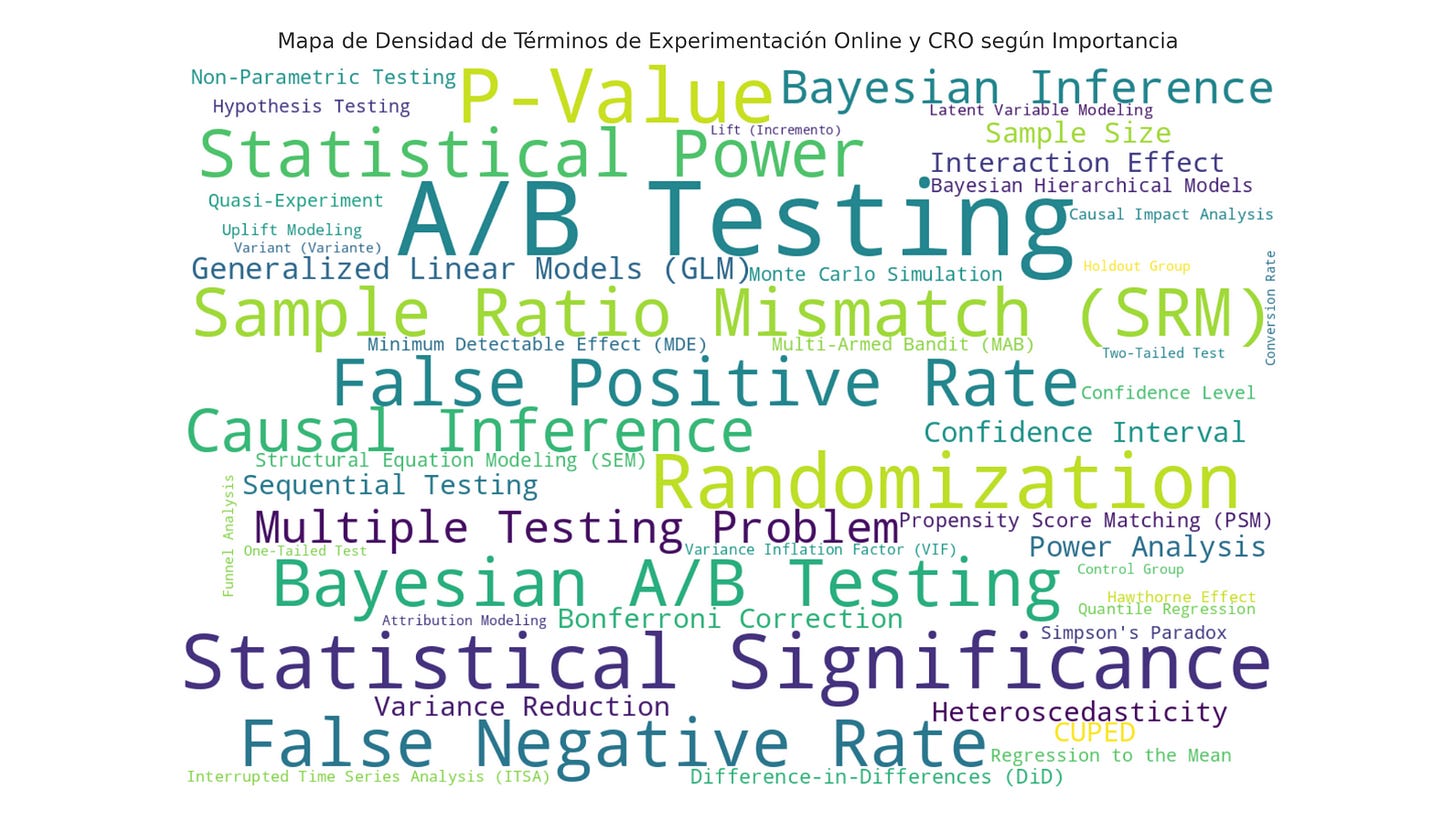

Al final de esta edición entenderás esta frase inicial. Originalmente iba a hacer un único glosario de términos y yo mismo me sorprendí cuando vi que se acumulaban más de 150. Así, he decidido hacer un listado temático en función de cada ámbito del CRO.

En esta 12ª edición se muestra un glosario de 51 conceptos de CRO dividido en tres apartados: términos que deben conocer profesionales entry-level, intermediate y advanced.

Ahora sí, empieza El Glosario de CRO orientado al dato.

Espero que os guste.

Conocer una definición no significa saber aplicarla en distintos contextos. No obstante, por algún sitio hay que empezar. Aquí tienes un listado de 51 términos divididos en función de la seniority del perfil, es decir, lo que creo que un entry-level, intermediate y advanced debería conocer.

Entry-level

Exploratory Data Analysis (EDA): Proceso preliminar de análisis de datos que utiliza técnicas visuales y estadísticas para identificar patrones, anomalías y características principales, facilitando la formulación de hipótesis iniciales.

Hypothesis Testing: Proceso de contrastar datos observados contra una hipótesis nula para evaluar si se debe rechazar en favor de la hipótesis alternativa, utilizando criterios estadísticos como la p-valor

Control Group: Grupo de referencia que no recibe el cambio experimental, utilizado para evaluar el efecto de la intervención mediante la comparación con el grupo tratado.

Variant: Versión del experimento con modificaciones aplicadas que se compara con el grupo de control para evaluar su impacto en las métricas objetivo.

Conversion Rate: Proporción de usuarios que completan la acción deseada (e.g., compra, registro) en un sitio web, utilizada como métrica clave en experimentos de optimización.

Nivel de significancia: Grado de certeza de que un resultado observado no se debe al azar, determinado mediante una prueba de hipótesis, usando un umbral de significancia predefinido (generalmente α = 0.05). Un resultado es estadísticamente significativo si la probabilidad de observarlo bajo la hipótesis nula es menor que este umbral.

Confidence Interval: Rango de valores calculado a partir de datos muestrales que, con una alta probabilidad, contiene el verdadero valor del parámetro poblacional. Por ejemplo, un intervalo de confianza del 95% para una media indica que, en el largo plazo, el 95% de los intervalos construidos a partir de diferentes muestras incluirán el valor verdadero de la media poblacional.

P-Value: Probabilidad de obtener un resultado igual o más extremo que el observado bajo la suposición de que la hipótesis nula es verdadera.

Minimum Detectable Effect (MDE): El efecto mínimo que un experimento puede detectar con una potencia y un nivel de significancia específicos, usado para planificar el tamaño de muestra.

Statistical Power: Probabilidad de detectar un efecto verdadero si este existe; un nivel comúnmente aceptado es del 80% o superior para asegurar la robustez de los resultados.

Sample Size: Número de observaciones requeridas para alcanzar un nivel de significancia y potencia especificados, determinante en la validez estadística del experimento.

Lift: Incremento porcentual en una métrica clave como resultado de la intervención, utilizado para medir el efecto de cambios en campañas y optimizaciones.

Rango intercuartílico (IQR): Medida de dispersión que representa la diferencia entre el tercer cuartil (Q3) y el primer cuartil (Q1), cubriendo el 50% central de los datos.

One-Tailed Test: Prueba de hipótesis que evalúa si el efecto de la intervención ocurre en una sola dirección (e.g., solo mejora en lugar de empeora).

Two-Tailed Test: Prueba de hipótesis que evalúa si el efecto de la intervención se manifiesta en cualquiera de las dos direcciones (mejora o empeora).

Outliers: Observaciones que se desvían significativamente de la tendencia general, lo que puede distorsionar las estimaciones y resultados si no se manejan adecuadamente.

Sample Ratio Mismatch (SRM): Desajuste en la proporción de asignación de muestras a cada grupo, indicando posibles errores en la aleatorización que pueden invalidar el experimento.

Intermediate

Bayesian A/B Testing: Método basado en inferencia bayesiana para evaluar la probabilidad de que una variante sea mejor que el control, proporcionando distribuciones posteriores en lugar de p-valor.

Sequential Testing: Técnica que permite monitorear resultados en intervalos continuos durante el experimento, controlando la tasa de error y evitando paradas tempranas incorrectas.

Interaction Effect: Fenómeno en el que el efecto de una variable independiente sobre la dependiente depende del nivel de otra variable, indicando efectos combinados no aditivos.

Análisis de Distribución: Evaluación de la forma, dispersión y patrones de una variable, usando gráficos y pruebas estadísticas para identificar sesgos y validar supuestos. Fundamental para interpretar diferencias entre grupos en experimentos.

Holdout Group: Subgrupo de usuarios que se excluye intencionalmente de un experimento para evaluar el impacto real de una intervención después de su implementación.

ANOVA: Prueba paramétrica que compara las medias de tres o más grupos para determinar si existen diferencias significativas entre ellos.

Kruskal-Wallis Test: Prueba no paramétrica que compara la distribución de tres o más grupos independientes cuando no se cumple la suposición de normalidad.

False Positive Rate: Proporción de veces que se rechaza incorrectamente la hipótesis nula, indicando un error de Tipo I.

False Negative Rate: Proporción de veces que no se rechaza la hipótesis nula cuando es falsa, indicando un error de Tipo II.

Campbell's Law: Principio que establece que cuando una métrica se utiliza como objetivo, tiende a distorsionarse al ser optimizada, perdiendo su valor como indicador.

Simpson's Paradox: Fenómeno en el cual una tendencia observada en grupos separados se invierte cuando los datos se combinan, revelando interpretaciones engañosas.

Engagement Bias: Sesgo que ocurre cuando usuarios altamente comprometidos tienen más probabilidad de ser expuestos a una intervención, sobreestimando el impacto del cambio.

Quasi-Experiment: Diseño experimental sin aleatorización completa, utilizado para estimar relaciones causales en entornos observacionales con menor control.

CUPED (Controlled Pre-Experiment Data): Técnica que utiliza datos previos al experimento para ajustar las métricas iniciales y reducir la varianza, mejorando la precisión.

Mann-Whitney U Test: Prueba no paramétrica utilizada para comparar dos grupos independientes cuando las distribuciones no son normales. Evalúa si la distribución de las observaciones difiere significativamente entre los grupos, basándose en la comparación de rangos.

Bonferroni Correction: Ajuste del nivel de significancia para reducir la probabilidad de falsos positivos cuando se realizan múltiples pruebas.

Welch’s T-Test: Prueba paramétrica que compara las medias de dos grupos cuando las varianzas son desiguales y los tamaños de muestra difieren.

Advanced

Double Machine Learning (DoubleML): Técnica de estimación causal que combina machine learning y métodos econométricos en dos etapas. Ajusta las covariables con modelos predictivos y luego realiza estimaciones causales en los residuos resultantes, minimizando el sesgo de regularización en entornos de alta dimensionalidad.

Stouffer's Test: Prueba combinatoria que utiliza el promedio ponderado de valores-Z de múltiples pruebas independientes para evaluar una hipótesis conjunta. Proporciona un valor-Z acumulado que ajusta la contribución de cada prueba según su tamaño muestral y varianza.

Interrupted Time Series Analysis (ITSA): Método cuasi-experimental que mide el impacto de una intervención observando cambios en la tendencia y el nivel de la serie temporal. Utiliza modelos lineales segmentados para detectar rupturas estructurales significativas antes y después del cambio.

Difference-in-Differences (DiD): Técnica para estimar el efecto causal de una intervención comparando cambios en grupos tratados y de control. Asume que las diferencias entre grupos habrían permanecido constantes en ausencia de la intervención (supuesto de paralelismo).

Hawthorne Effect: Fenómeno donde los sujetos cambian su comportamiento por saberse observados, generando un sesgo en los resultados experimentales. Frecuente en tests de UX y CRO, puede confundir el verdadero efecto del cambio.

Propensity Score Weighting (PSW): Técnica que ajusta las diferencias en covariables pretratamiento utilizando puntajes de propensión como pesos para cada observación. Emula un diseño experimental aleatorizado, mejorando la comparabilidad entre grupos.

Collinearity: Situación donde dos o más variables independientes están altamente correlacionadas, causando inestabilidad en las estimaciones de regresión. Resulta en coeficientes imprecisos y altos errores estándar, afectando la interpretación de los efectos individuales.

CUSUM (Cumulative Sum Control Chart): Técnica de monitoreo que detecta cambios en una serie temporal acumulando las desviaciones respecto a un valor de referencia. Identifica puntos de quiebre estructurales cuando el acumulado excede un umbral crítico.

ROC Curve: Gráfico que muestra la relación entre la tasa de verdaderos positivos (sensibilidad) y la tasa de falsos positivos a distintos umbrales. Evalúa la capacidad discriminativa de un modelo, siendo ideal para comparar clasificadores.

Monte Carlo Simulation: Técnica de simulación basada en distribuciones probabilísticas que evalúa la incertidumbre y el riesgo en sistemas complejos. Genera múltiples escenarios aleatorios para predecir el comportamiento bajo condiciones variables.

Bootstrapping Test: Técnica de remuestreo que crea múltiples subconjuntos de datos para estimar distribuciones e intervalos de confianza. Permite evaluar la significancia de resultados sin suponer normalidad, aumentando la robustez del análisis.

Bayesian Structural Time Series (BSTS): Modelo de series temporales bayesiano que usa componentes estructurales (tendencia, estacionalidad, ciclos) para construir contrafactuales. Mide el impacto de cambios en un entorno sin grupos de control.

Hierarchical Linear Models (HLM): Técnica de modelado para analizar datos organizados en niveles jerárquicos, estimando efectos simultáneos a diferentes niveles (e.g., usuario, página, campaña). Captura la variabilidad dentro y entre grupos.

R-Squared (R²): Medida de la proporción de variabilidad de la variable dependiente explicada por las independientes en un modelo de regresión. Indica qué tan bien las variables predicen el resultado observado, con valores más altos reflejando un mejor ajuste.

RMSE (Root Mean Square Error): Métrica que calcula la raíz cuadrada de la media de los errores cuadráticos entre valores predichos y reales. Indica la magnitud promedio de los errores, evaluando la precisión de los modelos en regresión.

ARIMA Models: Modelo de series temporales que combina componentes autorregresivos (AR), de diferenciación (I) y de media móvil (MA) para predecir valores futuros en datos estacionarios. Captura patrones históricos para extrapolar tendencias.

SARIMA Models: Extensión de ARIMA que incorpora componentes estacionales para modelar patrones recurrentes en intervalos regulares (e.g., mensuales, trimestrales). Ideal para series con estacionalidad marcada y variaciones cíclicas.

Como he dicho al principio, conocer y cantar como un loro los términos puede hacerlo cualquiera. Sin embargo, usarlos cómo y cuándo tocan es algo que va mucho más allá de tu capacidad de aprendizaje.

Requiere tiempo, sudor y cicatrices.

La práctica hace al maestro.